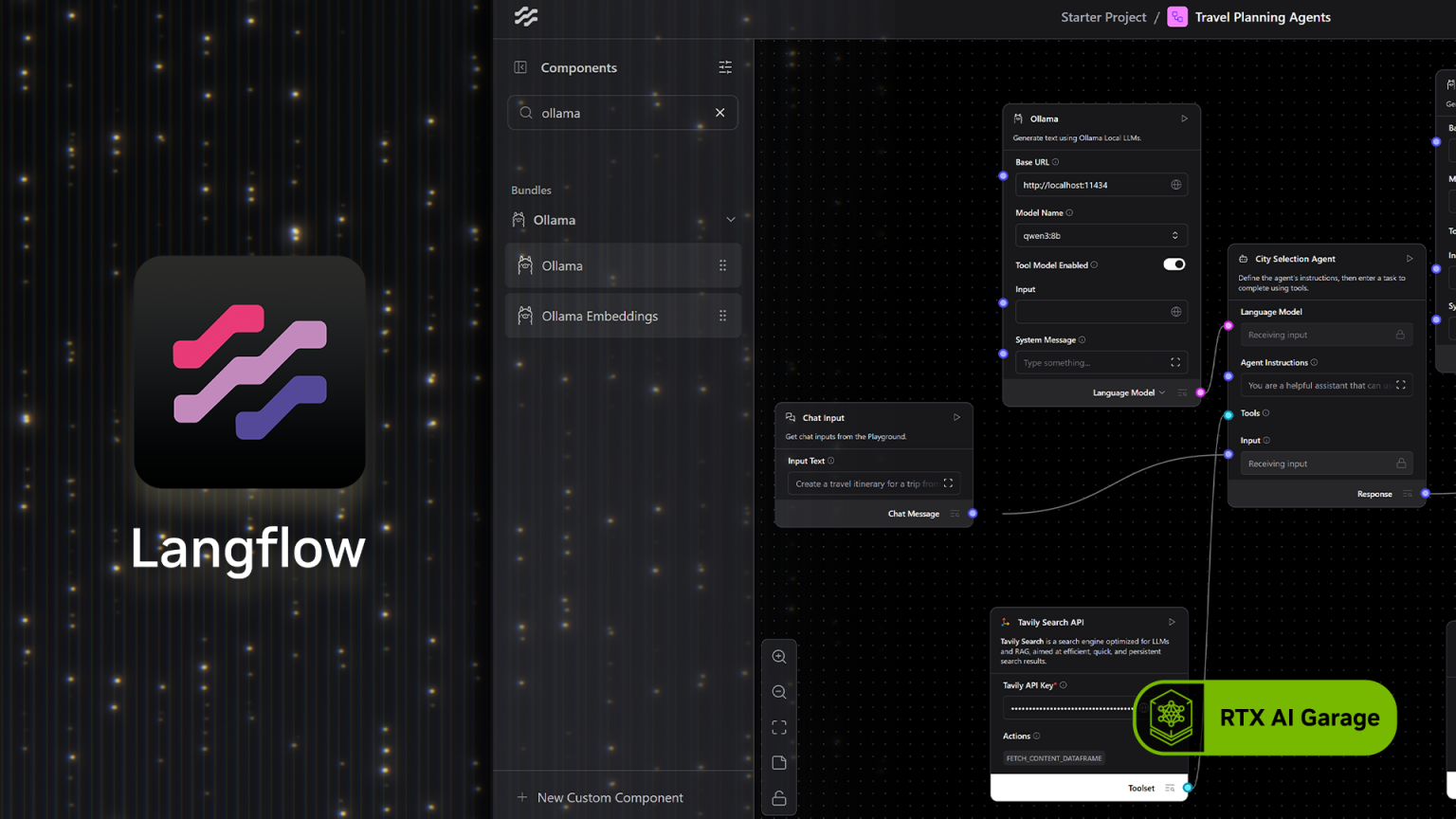

In der RTX AI Garage dieser Woche wird erläutert, wie AI-Enthusiasten Anwendungen wie Langflow nutzen, um generative AI-Modelle zu verketten. Dank der nativen Ollama-Integration können Nutzer nun lokale AI-Workflows erstellen und diese kostenlos und unter vollständiger Wahrung der Privatsphäre ausführen, unterstützt durch NVIDIA GeForce RTX– und RTX PRO-GPUs.

Langflow kann Modelle aus der Cloud oder lokal ausführen. Dabei wird die volle Beschleunigung für RTX-GPUs über Ollama genutzt. Die lokale Ausführung von Workflows bietet mehrere wichtige Vorteile:

- Datenschutz: Eingaben, Dateien und Eingabeaufforderungen bleiben auf das Gerät beschränkt.

- Niedrige Kosten und keine API-Schlüssel: Der Zugriff auf die Cloud-Anwendungsprogrammierschnittstelle ist nicht erforderlich, sodass keine Tokenbeschränkungen, Service-Abonnements oder Kosten im Zusammenhang mit dem Betrieb der AI-Modelle anfallen.

- Performance: RTX-GPUs ermöglichen eine Inferenz mit geringer Latenz und hohem Durchsatz, selbst bei langen Kontextfenstern.

- Offlinefunktionalität: Lokale AI-Workflows sind ohne Internetverbindung zugänglich..

Benutzer können RTX-AI-PCs jetzt auch mit Project G-Assist in Langflow steuern.

NVIDIA Project G-Assist ist ein experimenteller AI-Assistent, der lokal auf GeForce RTX-PCs läuft und es Nutzern ermöglicht, Systeminformationen abzurufen, Systemeinstellungen anzupassen und vieles mehr. All dies geschieht über einfache Eingaben in natürlicher Sprache.

Mit der G-Assist-Komponente in Langflow können diese Funktionen in benutzerdefinierte agentenbasierte Workflows integriert werden. Benutzer können G-Assist auffordern, „GPU-Temperaturen abzurufen“ oder „Lüftergeschwindigkeiten anzupassen“ und dessen Antworten und Aktionen werden über die gesamte Komponentenkette weitergeleitet.

*Auszug Pressemitteilung