PowerColor bietet eine breite Palette an unterschiedlichen Modellen der AMD RX5600 Serie an. Neben vier weiteren Modellen dieser Serie freuen…

Durchsuche: Grafikkarte

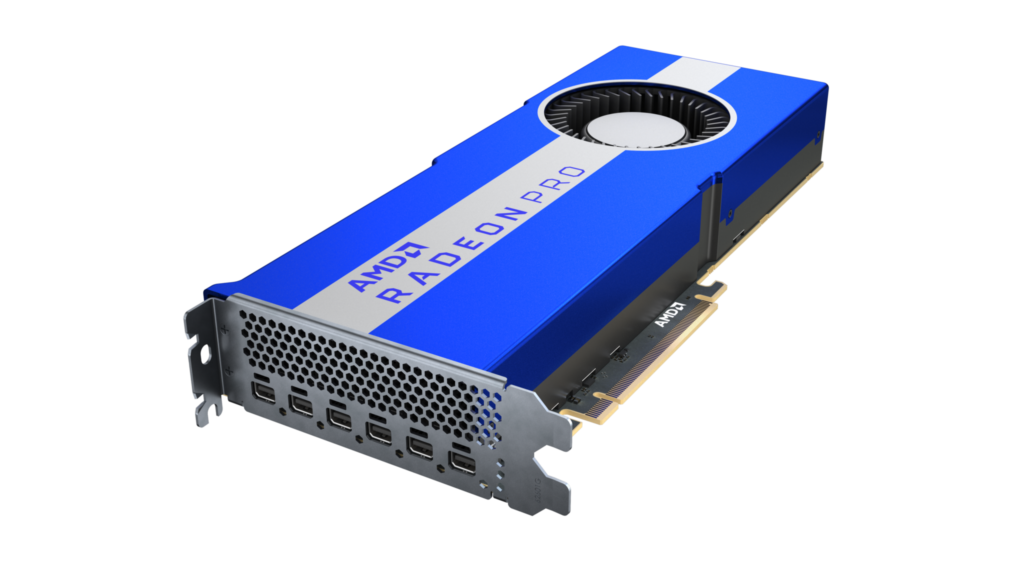

Die heute angekündigte neue Radeon Pro VII Workstation Grafikkarte ist für anspruchsvolle Broadcast-Workloads, komplexe CAE-Simulationen und HPC-Anwendungsentwicklung optimiert. Neben der…

Taipeh, Taiwan, GIGABYTE TECHNOLOGY Co. Ltd, einer der führenden Hersteller von Motherboards, Grafikkarten und Gaming-Hardware, hat heute die neue Grafikkarte…

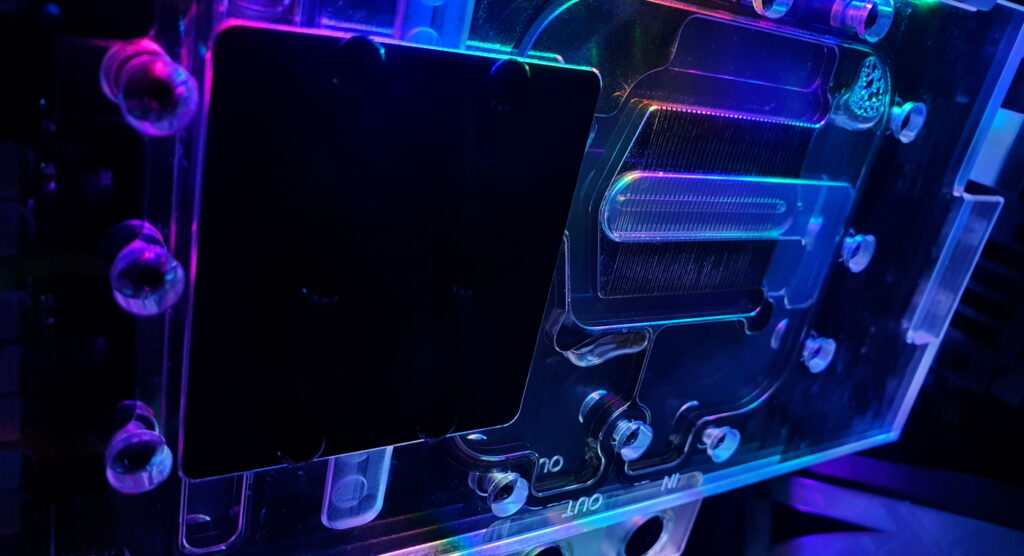

Mit dem Alphacool Eisblock GPX-N Plexi Light schauen wir uns heute einen Wasserkühler für die ASUS ROG STRIX RTX 2070…

Braucht euer System ein Upgrade mit mehr Grafikpower?Wir freuen uns, euch wieder ein Gewinnspiel mit unserem Partner ASUS Republic of…

NVIDIA gab als Antwort auf eine Support-Anfrage bekannt, dass die Quadro-Treiberunterstützung für ausgewählte Windows-Versionen ab dem 14. Januar 2020 eingestellt…

AMD hat mit der Veröffentlichung der Radeon RX 5700-Grafikkartenserie offiziell seine Navi-GPU-Architektur eingeführt, und langsam, aber sicher werden weitere SKUs…

Masooma Bhaiwala ist Intels jüngste Talentakquisition von AMD, die dort eine GPU-Produktreihe mit aufbaute. „Nach über 15 Jahren bei AMD…

BitFenix hat heute ein Zubehörteil für die Sicherheit Ihrer Grafikkarten angekündigt und welche Ihrem Build zusätzlichen Glanz verleihen. Die BitFenix…

Nachdem wir schon die GTX 1660 Ti und 1650 EX von KFA2 getestet haben, werfen wir heute einen Blick auf…

![GEWINNSPIEL ASUS ROG Strix Geforce RTX 2080 Super OC[Beendet]](https://www.hardwareinside.de/wp-content/uploads/2020/02/Asus-2080-Gewinnspiel33-1024x490.jpg)